|

||

|

Master Member

加入日期: Sep 2001 您的住址: K

文章: 1,504

|

看到無風扇不由得好奇起來,經過一番搜尋後也確實找到了賣家,

一看價錢5471rmb,嗯...就不知跟您買的是否相同賣家。 當然相較於搭配AI MAX+ 395的主機來講,這價錢算便宜就是。 引用:

|

||||||||

|

|

|

Senior Member

加入日期: Aug 2004

文章: 1,140

|

引用:

是的,只此一家,我也是全包約5100多人民幣,不過主機板也是建議選好一點的。(賣家可以代購代組) 精粵B650i 有點毛病,拔插頭下次就是clean bios才不會卡住,我還要找機換更新bios看看。 不過我的目標本來就只有影音需求,無風扇是好選擇,多點錢拚了。考慮把家裡幾台電腦都整併起來,簡單用一台就行。

__________________

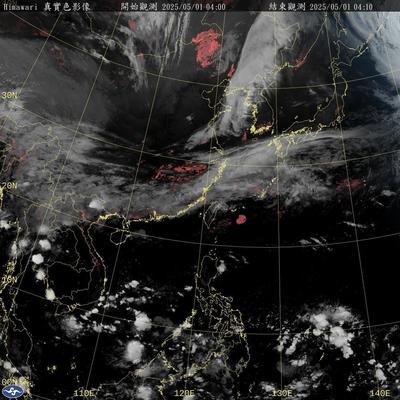

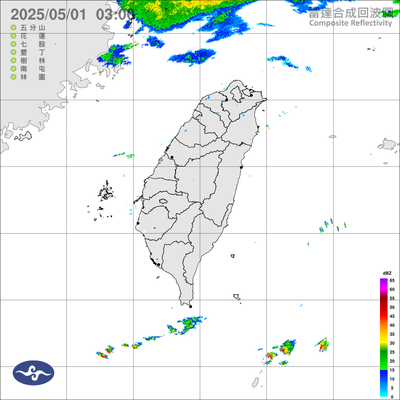

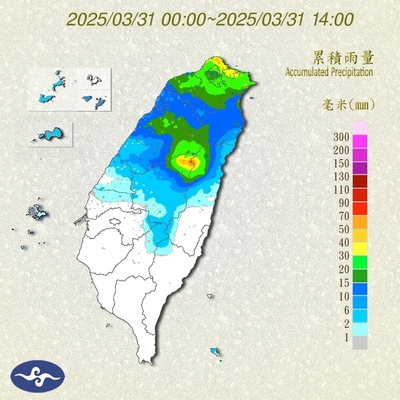

簽名小即時氣象雲圖

|

|||

|

|

|

Advance Member

加入日期: Aug 2004

文章: 360

|

https://www.youtube.com/watch?v=1N6a46QqdhI

斯波圖的影片. 現在要在自己家裡佈署AI機器, 不想用雲端伺服器, 除了價錢是個大問題外, NVIDIA顯卡配的顯存太小也是個問題. 我一直在想應該會有廠商推出大容量內存顯存共享的機器, 這台極犘客的GMK EVO-X2看起來很不錯. |

|

|

|

Master Member

加入日期: Sep 2001 您的住址: K

文章: 1,504

|

這玩意不便宜,個人建議不急的話先等一下...3nm或2nm的medusa halo會更好。

或是等medusa halo推出了再看有沒有辦法撿便宜。 引用:

|

|

|

|

|

Senior Member

加入日期: Aug 2001 您的住址: 台中or桃園

文章: 1,146

|

引用:

基本上5090可以解決你90%問題 不能的話就是你該上EPYC洋垃圾的時候 當初也想買strix halo 後來看開了先買HX365 32GB RAM, 非常爽 Strix Halo從發表到有實際機器可以賣大概要六到八個月 Medusa Halo大概也是, 所以最後先買先贏.. 附帶一提的是, 395跑LLM沒有想像中的快, 而記憶體不夠也是沒辦法也沒救的事實 (128GB對於QWEN3 30B來說效能過剩, 480B記憶體又差太遠. 235B Q4也放不下, 唯一適合的是70B Q4或是Q8, 但是Qwen3的30B比以前的llama 3 70B聰明) offload CPU因為share 主記憶體, 基本上最後變尷尬的定位 不考慮Ktransformer洋垃圾嗎? 如果你要的模型很小, AI 9 365/370 32GB記憶體就夠了 (32B Q4) |

|

|

|

|

Major Member

加入日期: Jun 2009

文章: 146

|

引用:

華為的300i duo可以看一下 預算夠可自己堆deepseek 此文章於 2025-08-09 11:05 AM 被 linkt 編輯. |

|

|

|

|

Elite Member

加入日期: Mar 2001 您的住址: Rivia

文章: 7,057

|

昨天 llama.cpp 有打雞血 --cpu-moe

無腦使用速度幾乎比之前快了三倍 gpt-oss 120B 使用 8GB vram 的 3090 就有 18tks

__________________

Folding@home with GPGPU集中討論串 Unix Review: ArchLinux●Sabayon●OpenSolaris 2008.5●Ubuntu 8.10 AVs Review: GDTC●AntiVir SS●ESS●KIS 09●NIS 09●Norton 360 V3  I Always Get What I Want. |

|

|

|

Advance Member

加入日期: Aug 2004

文章: 360

|

Minisforum要出一台N5 Pro, AI + NAS, 不含DRAM, 大概3萬多不到4萬台幣, 一個有趣的設計是主機板是可以抽換的. 另一台低規格的N5, 售價大概是N5 Pro的一半.

|

|

|

|

Golden Member

加入日期: Aug 2004 您的住址: 北極星

文章: 2,613

|

我買的minisforum UM690S保內掛了...

雖然已找到可代送的賣家 不過還是來問問大家 遇到故障是怎麼送修到中國的?? |

|

|

|

Advance Member

加入日期: Aug 2004

文章: 360

|

引用:

集運可以. 如果有在用集運, 問一下有沒有收台灣寄大陸的貨. 我寄過一次. |

|

|

|